Mixture-of-Mamba

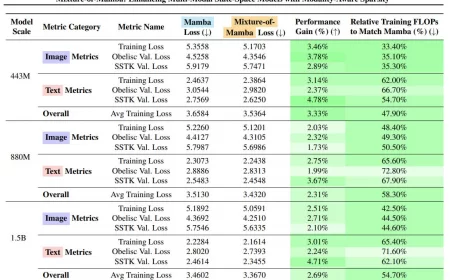

Mixture-of-Mamba — это новая архитектура, разработанная для обработки мультимодальных данных, таких как текст, изображения и речь, с высокой эффективностью и меньшими вычислительными затратами. Она основана на State Space Models (SSMs) и является развитием модели Mamba, но с улучшенной разреженностью, зависящей от модальности (modality-aware sparsity). Это делает её более эффективной в сравнении с обычными Transformer-архитектурами и стандартными SSM.

Основная идея

В обычных нейросетях все входные данные обрабатываются одинаково, независимо от их типа (текст, изображение, звук). Это приводит к избыточным вычислениям и неэффективному использованию параметров модели. Mixture-of-Mamba решает эту проблему, адаптируя обработку под каждый тип данных.

Что делает Mixture-of-Mamba уникальной?

- В отличие от стандартных Mamba, которые применяют одни и те же параметры ко всем входным данным, Mixture-of-Mamba использует отдельные параметры для разных модальностей.

- Позволяет модели динамически выбирать, какие параметры и вычислительные ресурсы задействовать в каждом конкретном случае.

- Снижает затраты на обучение и делает обработку мультимодальных данных быстрее.

Как это работает?

- Входные данные поступают в систему (текст, изображения, речь).

- Модуль выбора модальности анализирует данные и решает, какие параметры модели должны быть активированы.

- Каждый тип данных обрабатывается отдельными наборами параметров:

- Текст использует одни веса,

- Изображения — другие,

- Речь — третьи.

- Результаты объединяются, формируя финальный вывод модели.

- Экономия вычислительных ресурсов за счёт того, что неиспользуемые параметры модели остаются «выключенными».

Пример из реальной жизни

Представьте, что у вас есть универсальный переводчик, который умеет читать, слушать и видеть. Но вместо того чтобы использовать одну и ту же стратегию для всех данных, он работает так:

- Когда ему показывают текст, он использует лингвистический анализ.

- Когда дают изображение, он включает нейросеть для распознавания картинок.

- Когда дают звук, он использует специальную модель для обработки речи.

В отличие от обычного переводчика, который использует все методы одновременно, Mixture-of-Mamba задействует только нужные части, экономя время и ресурсы.

Чем Mixture-of-Mamba лучше стандартных моделей?

| Характеристика | Mixture-of-Mamba | Стандартные модели (Mamba, Transformers) |

|---|---|---|

| Обработка мультимодальных данных | Адаптивная (разные параметры для текста, изображений, речи) | Универсальная (одни параметры для всех) |

| Эффективность вычислений | Тратит до 65% меньше ресурсов | Вычисляет всё сразу, даже если часть параметров не нужна |

| Обучение | Быстрее достигает нужного качества | Требует больше времени и ресурсов |

| Гибкость | Можно легко добавлять новые типы данных | Трудно адаптировать без переобучения |

Какие задачи решает Mixture-of-Mamba?

✔️ Мультимодальное обучение (работает с текстом, изображениями и аудио).

✔️

Генерация изображений и видео (оптимизирована для работы с диффузионными моделями).

✔️

Обработка речи (может быть полезна для голосовых помощников).

✔️

Оптимизация больших языковых моделей (работает быстрее и экономит вычислительные ресурсы).

Заключение

Mixture-of-Mamba — это новый шаг в развитии разреженных нейросетей, который позволяет эффективнее обучать и использовать мультимодальные модели. Она совмещает плюсы Mixture-of-Experts (MoE) и State Space Models (SSMs), делая мультимодальное обучение более быстрым и дешёвым.

Если вам нужна мощная модель, работающая с текстом, изображениями и аудио, но при этом потребляющая меньше вычислительных ресурсов, Mixture-of-Mamba — идеальный вариант!

Этот материал будет дорабатываться, а пока он находится в статусе черновика.