OmniHuman-1 от ByteDance: новая эпоха дипфейков или угроза безопасности?

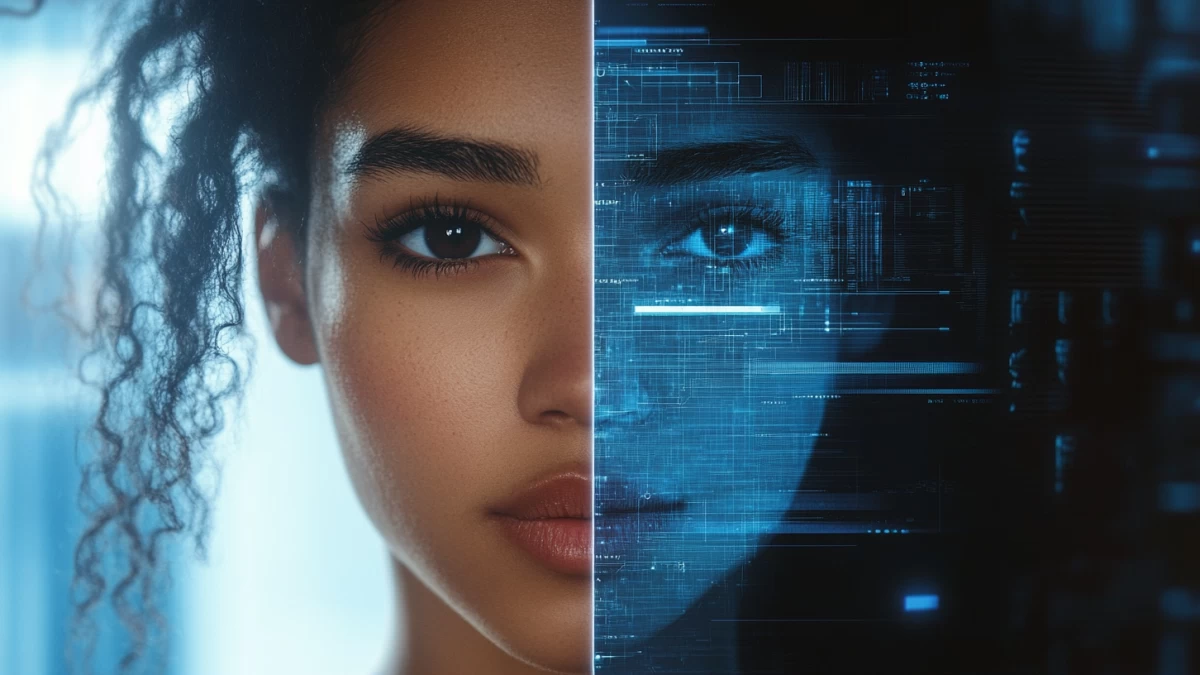

Технологии дипфейков уже широко распространены, но до сих пор большинство подобных видео выглядели неестественно. Человеческий глаз обычно замечает несовпадение мимики, артефакты или странные движения губ, что выдает подделку.

OmniHuman-1 ломает этот барьер. По словам разработчиков, система требует всего одного изображения и звукового файла (например, речи или вокала), чтобы создать видео любой длительности с настраиваемым аспектным соотношением и пропорциями тела.

«Качество настолько высокое, что дипфейки практически невозможно отличить от реального видео», — утверждают исследователи ByteDance.

Что это значит для мира?

OmniHuman-1 пока не выпущен в открытый доступ, но, как показывает практика, подобные модели быстро подвергаются обратной разработке и начинают распространяться среди ИИ-энтузиастов и киберпреступников.

Опасения вполне обоснованы. Дипфейки уже использовались для политических манипуляций по всему миру:

- На выборах в Тайване в 2024 году китайская проправительственная группа распространила поддельную запись политика, заявляющего о поддержке пророссийского кандидата.

- В Молдове появился дипфейк с фальшивым заявлением президента Майи Санду о ее якобы отставке.

- В Южной Африке в преддверии выборов распространилось видео с рэпером Эминемом, якобы поддерживающим оппозицию.

Но политика — не единственная сфера, где дипфейки создают проблемы. В 2023 году мошенники использовали ИИ для финансовых преступлений, выдавая себя за знаменитостей и убеждая пользователей инвестировать в фальшивые схемы.

По данным Deloitte, дипфейки уже привели к мошенничествам на сумму более $12 млрд, а к 2027 году эта цифра может вырасти до $40 млрд только в США.

Почему дипфейки так сложно остановить?

Проблема заключается в низкой скорости реагирования на распространение дипфейков. В 2024 году более 60% опрошенных пользовались дипфейками, а 72% заявили, что опасаются быть обманутыми ежедневно.

Некоторые соцсети и поисковики уже начали бороться с ИИ-контентом, но объем таких подделок растет в геометрической прогрессии.

В феврале 2024 года сотни ИИ-экспертов подписали открытое письмо, требуя срочного регулирования дипфейков на уровне закона. В США 10 штатов уже приняли законы против подделок с использованием ИИ, а в Калифорнии рассматривается законопроект, позволяющий требовать удаления дипфейков через суд.

OmniHuman-1 демонстрирует, что дипфейки достигли нового уровня реалистичности. С одной стороны, эта технология открывает огромные возможности в киноиндустрии, рекламе и создании контента. С другой — она несет серьезные риски для политики, финансов и персональной безопасности.

Пока же мир стоит перед вызовом: как контролировать ИИ, который может полностью изменить реальность?