Meta продемонстрировала, как с помощью оперативной инженерии можно уменьшить количество искажений в ChatGPT & Co.

ChatGPT и другие языковые модели постоянно воспроизводят неверную информацию - даже если они выучили всё правильно. Существует несколько подходов к снижению уровня несоответствий. Исследователи из Meta AI представили метод Chain-of-Verification (CoVe), основанный на подсказках, который значительно снижает эту проблему.

Новый метод основан на самопроверке языковой модели.

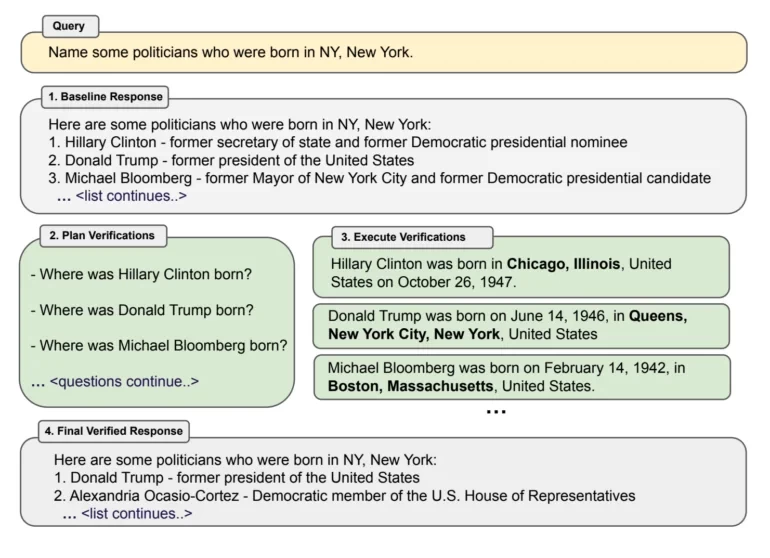

При использовании CoVe чат-бот сначала отвечает на запрос типа: "Назовите политиков, которые родились в Нью-Йорке". На основе полученного результата, который зачастую уже содержит ошибки, языковая модель генерирует вспомогательные вопросы для уточнения, например "Где родился Дональд Трамп?".

Эти "проверочные вопросы" выполняются как новая подсказка, не зависящая от первого ввода, чтобы предотвратить возможное принятие неверной информации из первого вывода. Затем языковая модель проверяет первый ввод на соответствие отдельно собранным фактам. Все испытания проводились на Llama 65B.

Алгоритм проверки значительно уменьшает количество ошибок в языковых моделях

Команда показала, что ответы на отдельные вопросы содержат значительно меньше ошибок, что позволяет CoVe существенно улучшить итоговый вывод на запрос. Для вопросов, основанных на списках, таких как пример с политиками, CoVe может более чем удвоить точность, значительно снизив процент ошибок.

Для более сложных сценариев с вопросами и ответами метод по-прежнему дает 23-процентное улучшение, и даже для длинного контента CoVe повышает точность фактов на 28%. Однако при работе с длинным контентом команде также необходимо проверять проверочные ответы на наличие несоответствий.

В своих тестах команда Meta также продемонстрировала, что настройка инструкций и цепочки подсказок не уменьшают галлюцинации, поэтому Llama 65B с CoVe выигрывает у более новой модели Llama 2 с настройкой инструкций. В длинном контенте модель с CoVe также превосходит ChatGPT и PerplexityAI, которая может собирать внешние факты для своих будущих построений ответов. CoVe полностью работает со знаниями, хранящимися в модели.

Однако в будущем этот метод можно улучшить за счет сторонней информации, например, позволив языковой модели отвечать на проверочные вопросы путем доступа к внешней базе данных.